Screaming Frog (https://www.screamingfrog.co.uk) é uma excelente ferramenta para rastrear sites e extrair dados, mas se não estiver rastreando todos os URLsSe o Screaming Frog não estiver rastreando todos os URLs, você não estará realizando uma auditoria técnica de SEO de qualidade (auditoria de meta descrições na página, códigos de resposta, links internos, verificação de conteúdo duplicado, títulos de página, backlinks, textos alternativos etc.) em seus sites de comércio eletrônico. Nesta postagem do blog, examinaremos por que o Screaming Frog não está rastreando todos os URLs e como você pode corrigir o problema. Portanto, se você estiver tendo problemas para fazer com que o Screaming Frog rastreie todos os seus URLs, fique atento! Você terá uma surpresa.

Tabela de Conteúdos

- Como consertar o Screaming Frog não rastejando todos os URLs

- O site é bloqueado por robôs.txt.

- O atributo 'nofollow' está presente nos links que não estão sendo rastreados.

- A página tem um atributo "nofollow" de nível de página.

- O Agente-usuário está sendo bloqueado.

- O site requer JavaScript.

- O site requer Cookies.

- O site utiliza framesets.

- O cabeçalho Content-Type não indicava que a página era HTML.

- Conclusão

- Perguntas frequentes

Como consertar o Screaming Frog não rastejando todos os URLs

Há vários motivos pelos quais o Screaming Frog pode não rastrear todos os subdomínios em um websiteO mais comum é que o site tenha sido configurado para bloquear rastejadores como o Screaming Frog.

O site é bloqueado por robôs.txt.

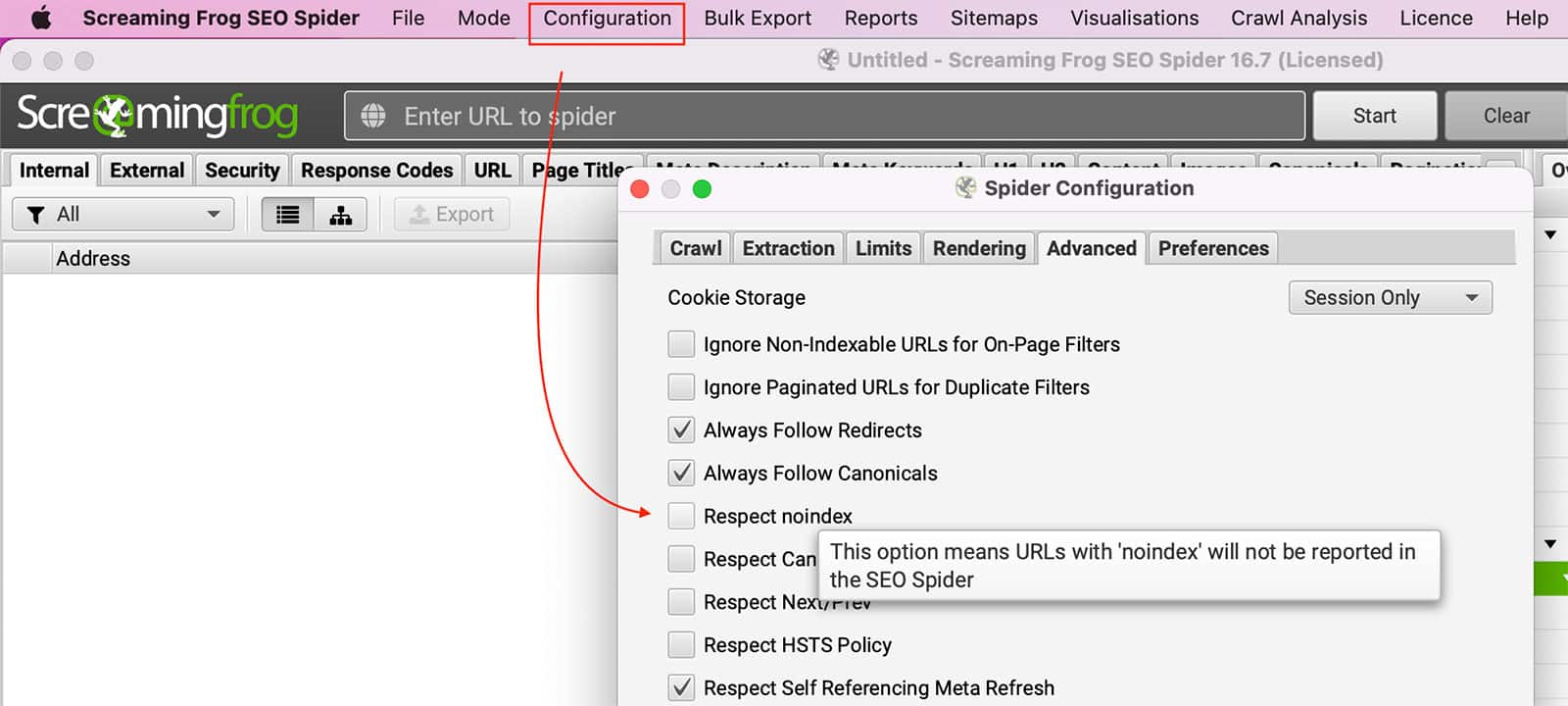

Robots.txt pode bloquear Sapo gritante rastrear páginas. Você pode configurar o SEO Spider para ignorar o robots.txt acessando Configuração >> Aranha >> Avançado >> Desmarque Respeito Noindex cenário.

Você também pode mudança seu Agente do usuário para GoogleBot para ver se o site permite esse rastreamento.

Robots.txt é usado para instruir os rastreadores da Web, ou "bots", sobre o que eles têm permissão para acessar em um determinado site. Quando um bot tenta acessar uma página que é especificamente proibida no arquivo robots.txt, ele recebe uma mensagem de que o webmaster não quer que essa página seja rastreada. Em alguns casos, isso pode ser intencional. Por exemplo, o proprietário de um site pode querer impedir que os bots indexem informações confidenciais. Em outros casos, pode ser simplesmente devido a um descuido. Independentemente do motivo, um site bloqueado pelo robots.txt ficará inacessível para qualquer pessoa que tente rastreá-lo.

O atributo 'nofollow' está presente nos links que não estão sendo rastreados.

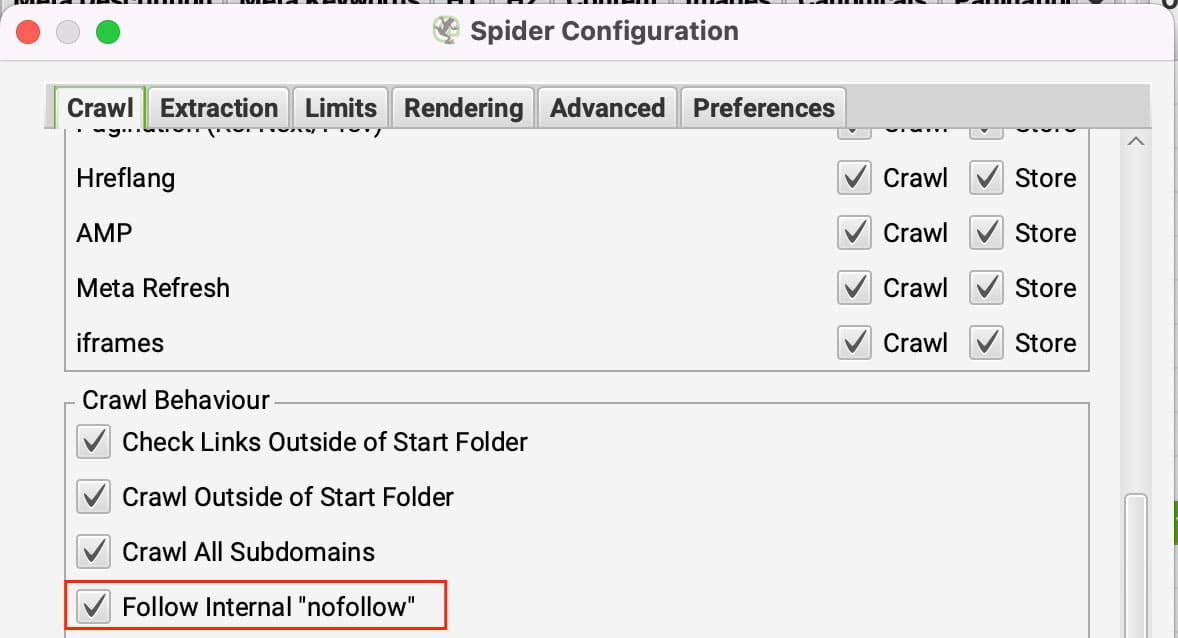

Os links Nofollow fazem como pretendido, eles dizem rastejadores para não seguir os links. Se todos os links estiverem definidos como nofollow em uma página, o Screaming Frog não terá para onde ir. Para contornar isso, você pode configurar o Screaming Frog para seguir links internos nofollow.

Você pode atualizar esta opção em Configuração >> Aranha sob o Aba Crawl clicando em Seguir o "nofollow" interno links.

A página tem um atributo "nofollow" de nível de página.

O atributo nofollow de nível de página é definido por uma meta tag robots ou uma X-Robots-Tag no cabeçalho HTTP. Eles podem ser vistos na guia "Diretivas" no filtro "Nofollow". O atributo nofollow no nível da página é usado para impedir que os mecanismos de pesquisa sigam os links em uma página.

Isso é útil para páginas que contêm links para fontes não confiáveis ou sem importância. Ao definir o atributo nofollow, você está informando aos mecanismos de pesquisa que eles não devem seguir os links da página. Isso ajudará a melhorar a classificação do seu site nos mecanismos de pesquisa, mas impedirá que você rastreie o site.

Para ignorar as tags Noindex, você deve ir para Configuração >> Aranha >> Avançado >> Desmarque o Respeito noindex cenário.

O Agente-usuário está sendo bloqueado.

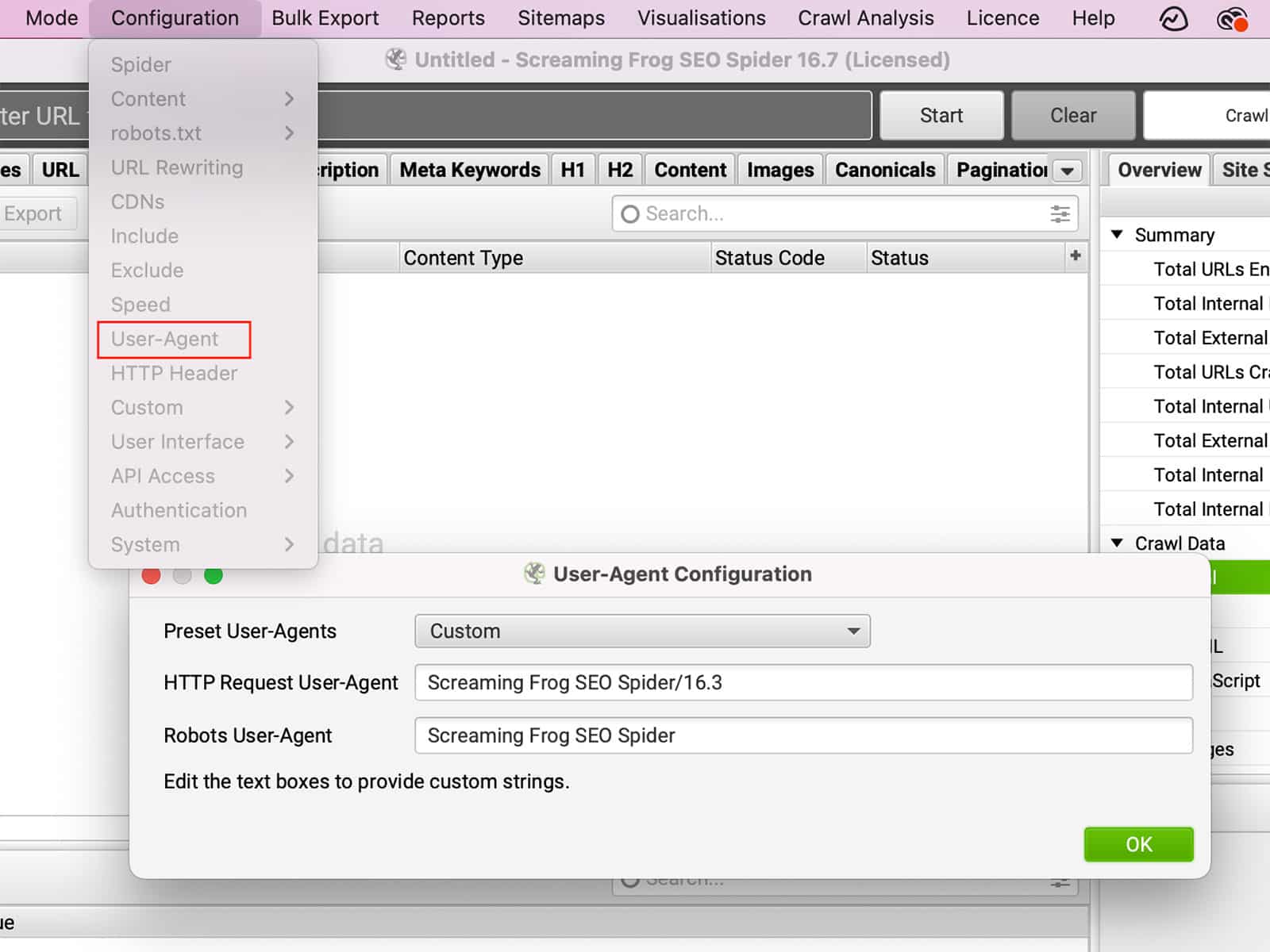

O Agente-usuário é uma seqüência de texto que é enviada por seu navegador para o site que você está visitando. O Agente-usuário pode fornecer informações sobre seu navegador, sistema operacional e até mesmo sobre seu dispositivo. Com base nestas informações, o website pode mudar a maneira como se comporta. Por exemplo, se você visitar um site usando um dispositivo móvel, o site pode redirecioná-lo para uma versão do site que seja amigável para o celular. Alternativamente, se você mudar o Agente Usuário para fingir ser um navegador diferente, talvez você possa acessar recursos que não estão disponíveis em seu navegador real. Da mesma forma, alguns sites podem bloquear certos navegadores por completo. Ao mudar o Agente-usuário, você pode mudar a maneira como um site se comporta, dando-lhe mais controle sobre sua experiência de navegação.

Você pode mudar o Agente-usuário sob Configuração >> Agente-usuário.

O site requer JavaScript.

JavaScript é uma linguagem de programação comumente usada para criar páginas da Web interativas. Quando o JavaScript está ativado, ele pode ser executado automaticamente quando uma página é carregada, possibilitando que os itens da página sejam alterados sem a necessidade de atualizar a página inteira. Por exemplo, o JavaScript pode ser usado para criar menus suspensos, exibir imagens com base na entrada do usuário e muito mais. Embora o JavaScript possa ser benéfico, alguns usuários preferem desativá-lo no navegador por vários motivos. Um dos motivos é que o JavaScript pode ser usado para rastrear a atividade de navegação de um usuário. No entanto, A desativação do JavaScript também pode causar problemas na exibição de um site ou no funcionamento de determinados recursos.

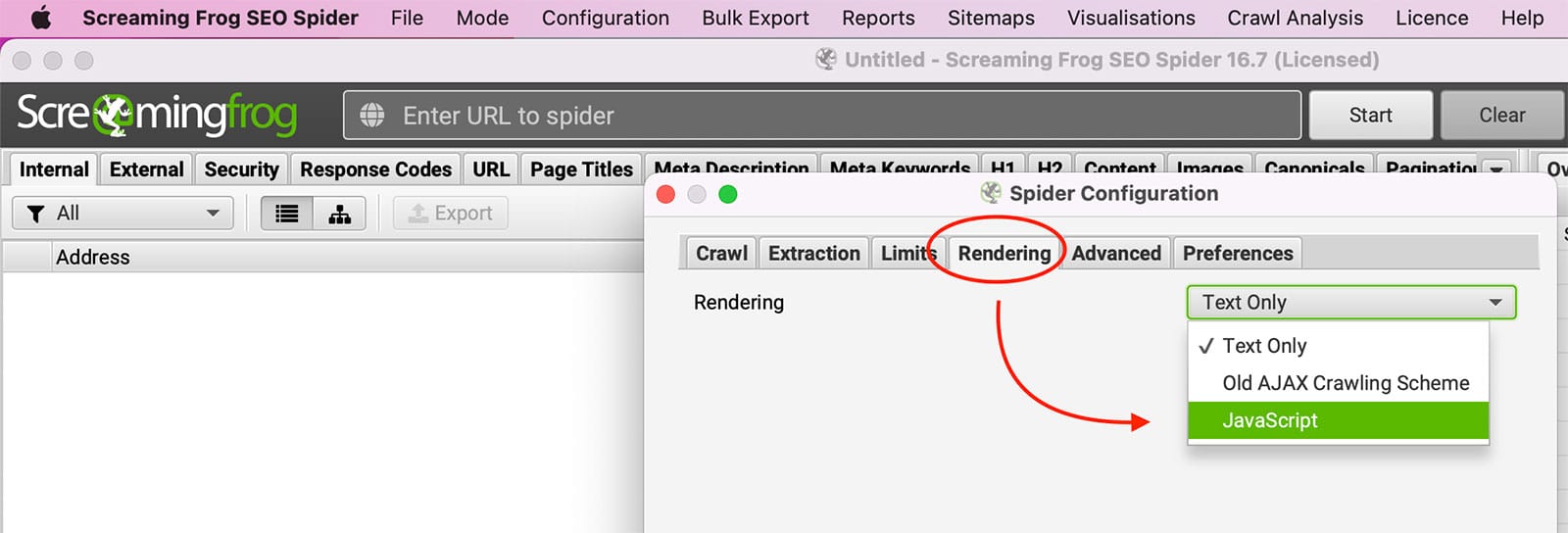

Tente permitindo a renderização javascript dentro do Screaming Frog under Configuração >> Aranha >> Renderização.

O site requer Cookies.

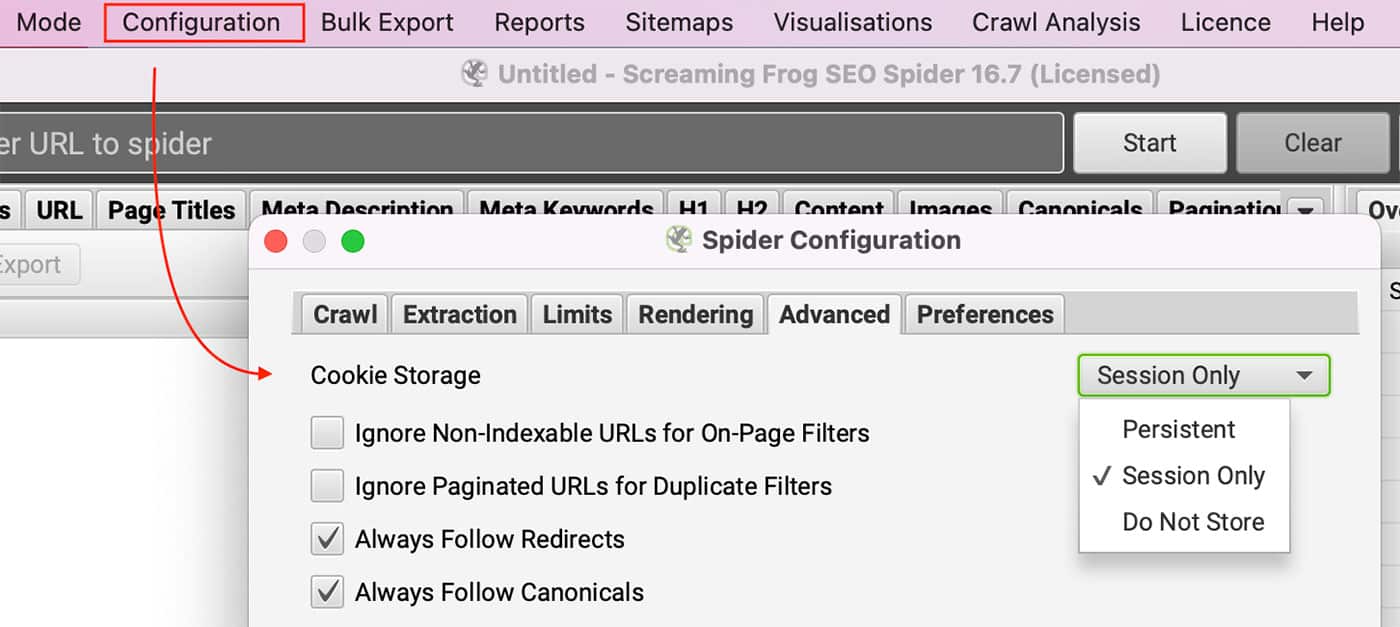

Você pode visualizar o site com os cookies desabilitados em seu navegador? Os usuários licenciados podem habilitar os cookies indo para Configuração >> Aranha e selecionando Sessão apenas em Armazenamento de biscoitos no Aba Avançado.

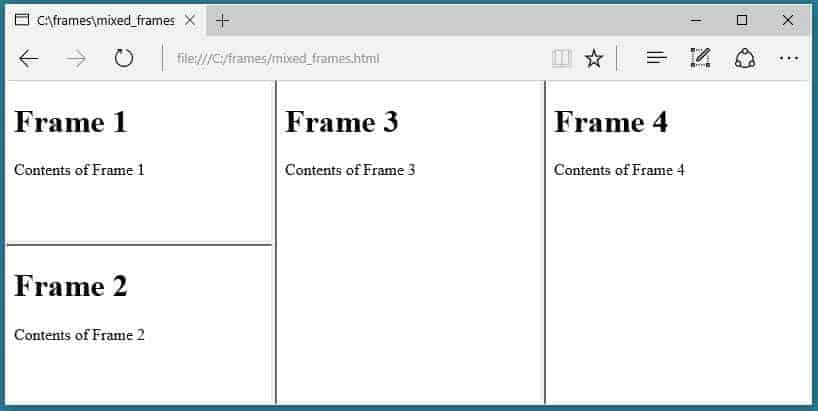

O site utiliza framesets.

A Aranha SEO não rasteja o atributo framesrc.

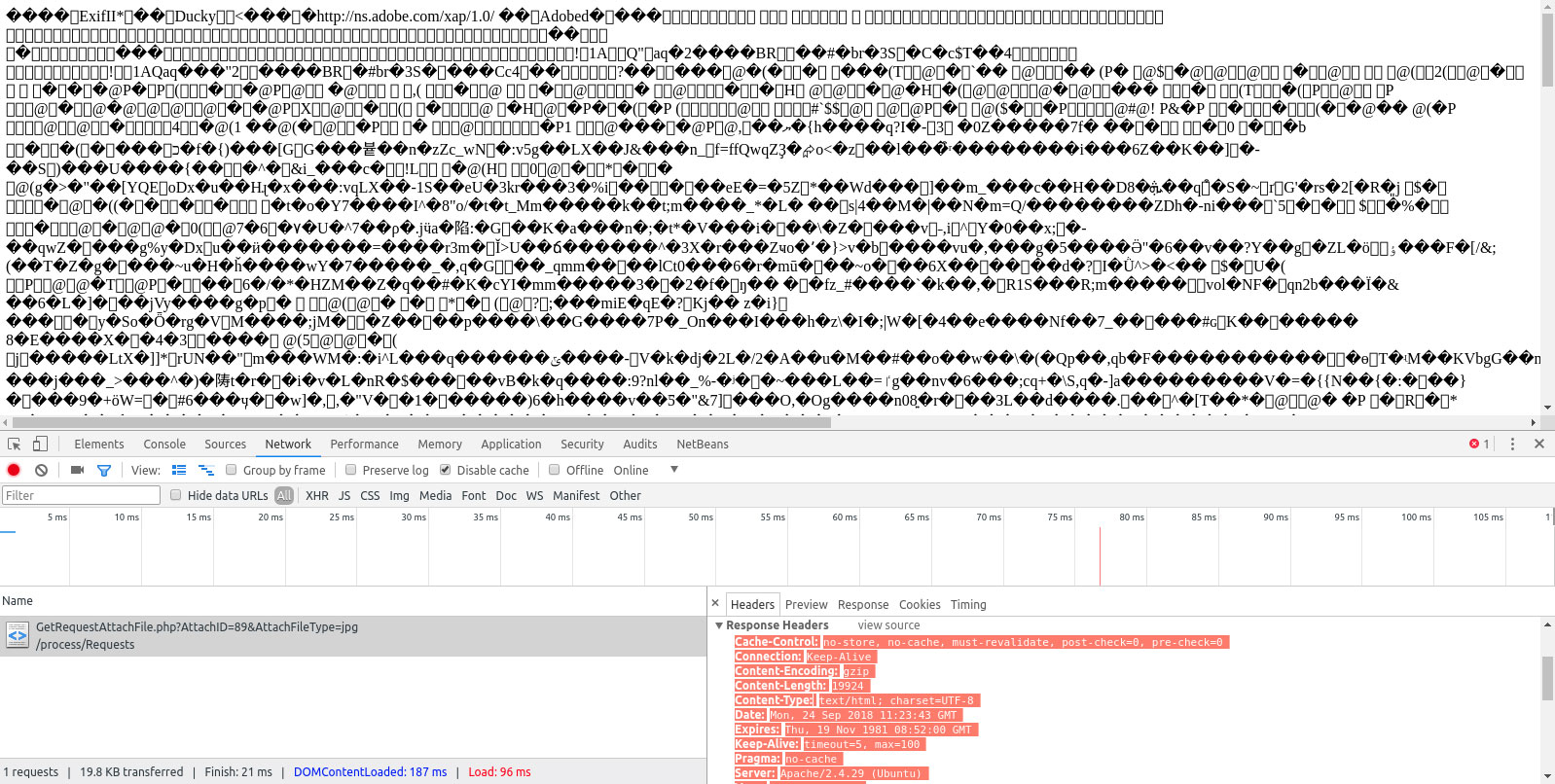

O cabeçalho Content-Type não indicava que a página era HTML.

Isto é mostrado na coluna Conteúdo e deve ser ou texto/HTML ou aplicação/xhtml+xml.

Conclusão

O spider de SEO do Screaming Frog pode ser uma excelente ferramenta para auditar seu site, mas é fundamental garantir que todos os URLs sejam rastreados. Se você não estiver obtendo os dados completos de que você precisa em suas auditoriasSe o Screaming Frog estiver configurado, pode haver um problema com a forma como ele está configurado. Esta postagem do blog analisou por que Sapo gritante O Screaming Frog pode não estar rastreando todos os seus URLs e como corrigir o problema. Ao corrigir esses problemas, você poderá obter dados mais abrangentes de suas auditorias do Screaming Frog e melhorar sua estratégia de SEO. Você já experimentou usar o Screaming Frog para as auditorias de seu website? Que dicas você tem para melhorar sua funcionalidade?

Perguntas frequentes

Por que o Screaming Frog não está rastejando todos os URLs?

Publicado em: 2022-06-07

Atualizado em: 2024-09-16